黄文博/祝洁 iCDO翻译志愿者

如果你已经尝试了所有方法,但产品的转化率依然处于下滑趋势,那么对比测试可能是导致这种现象的罪魁祸首。

是的,就是对比测试,这个传说中的流量开关、转化率助推器、自诩为目标用户提供支持策略的重要贡献者,却很少兑现它的承诺,导致虽然有些广告策划做的很棒,但最终却取得了失败。

在你大张旗鼓开始着手进行实验之前,我想一开始就向你澄清,这种宣称能够发现顾客喜好、激发用户热情并且能够一直带给他们最好体验的对比测试,其本身确实是一种靠谱的策略。任何一个经营活动都应该使用这种策略。

但是很遗憾,很多对比测试服务只会让你一知半解。今天就让我们一起深度挖掘一下到底是什么原因引出了这样的问题,以及如何处理。

对比测试最大的误区

前提很简单:制作两个或更多版本的页面。均分流量然后评估结果。但是这恰恰是让事实得以水落石出,让缺陷暴露无遗的地方。

事实上,你所收集的零散信息已经试着说服你相信一种选择会好于另一种选择,这个时候你本应该自然而然的就知道该怎样处理这样的结果。

例如,运用SumAll对同一页面进行了两种相同版本的对比测试 。测试结果表明第一个版本以将近20%的幅度明显优于第二个版本。

(Optimizely已经修改了他们的统计系统来阻止这样的缺陷混淆结果)

这说明了对比测试中一个很重要的问题:那就是你可以预测到业绩能够获得大幅增长的点,但如果你不将其转变成为可操作并且可以对直接收益产生影响的步骤,这些预测所产生的结果也是徒劳无用的。

你不知道的神秘统计秘密

冒着听起来太像Kevin Trudeau的转化率优化版本的危险,大多数对比测试和优化公司并不是真的要掏空你的银行账户,而什么都不留给你留下。他们会采用一种大而隐蔽的方式来使你感觉自我良好。

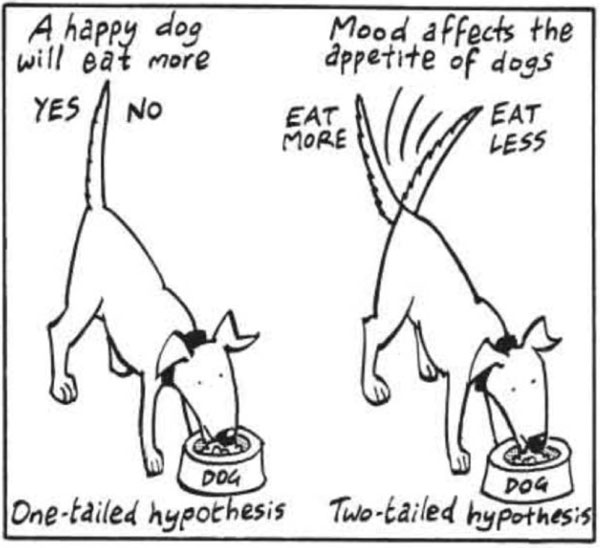

当需要通过不同的平台来完成对比测试时,,结果会有一些出入。比如 Visual Website Optimizer 和Optimizely可以进行所谓的“单尾”测试, 而另一些,如Adobe Test&Target 和Monetat可以做“双尾”测试。

那么两者之间有何不同,我们为何需要关注呢?

SumAll把这种测试带到了这里,这将对你未来的对比测试产生巨大影响。为了更好的解释这种想法,打个比方。

单尾测试寻求的是积极的相关性,就好像一直在牌桌上赢牌一样,那些并不真正懂,或者不在乎对比测试细节的高管们偏爱单尾测试,因为他们看起来总是在坐庄。这听起来对网站和用户都有好处,更不用说是工作的保障了。但这里有一个大问题,即单尾测试披着统计外衣的皮,并不能带来有意义的分析。

接下来是双尾测试。

双尾测试考量的是在过程中可能发生的事情的正面和反面,你需要更多的数据支撑来得出结论,但结论揭示了一些在单尾测试中找不到的点。

但这并不总是意味着双尾测试带来的都是正确的答案。在一些情况下,你需要用证据去验证一个具体测试中的积极结果。而单尾测试仅需要少量的资源进行验证便能得到结论。重点是你要知道自己考量的是什么,清楚这个因素在多大程度上直接影响到了你的底线和转化率,以及在多大程度上这个因素只是个噱头。

统计学的巅峰

我曾经写过“统计学意义”,讲的是它为什么很重要以及它是如何影响你的测试结果的。

在收集到足够的信息之前,许多对比测试往往就已为你展现了一个倾向于取胜的选项。测试可能会挑选出有90%统计学意义的赢家,你也按照这个结果对网站做出了改变,当然你的用户会察觉到这些变化,特别是那些以前访问过的用户,因为网站变得有所不同了。这些改变也许会让你的转化率受到波动,但只是暂时受到波动而已。

如果你没有足够的流量进行对比测试,是否能得出具有统计意义的结论?那么你需要知道这个事实,很多的服务商为了谋取利益会降低门槛并告诉你,只需要100个用户访问或者更低的数量便能测试出结果。

这对你是不公平的,这对每一个对比测试工具的使用者都会产生巨大的伤害。

你可以做什么?

这篇文章并不是意在抨击优化转化率的工具平台,而是想告诉你,使用这些工具,你真正能得到的是什么。庆幸的是,这里有些方法可以供你使用,并且可以使你的对比测试实验真正有效,为你提供真正的结果,并真正持续的提升你的转化率。

当进行对比测试时,你怎么能够判定得到的结果是实实在在且具有深度洞察的结果,而不只是隔靴搔痒的结果呢?

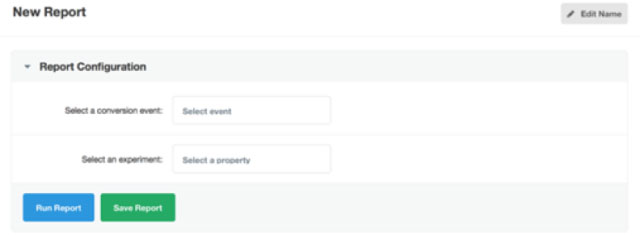

你仍然可以使用你喜欢的工具创建一个测试,但如果想要更好的看到它是如何进行的,我们还是使用Kissmetrics的仪表板创建一个A/B测试报告。Kissmetrics集成了多种对比测试的工具。然后,简单的创建一个新的报告,选择一个实验以及一个转化事件,如下图所示。

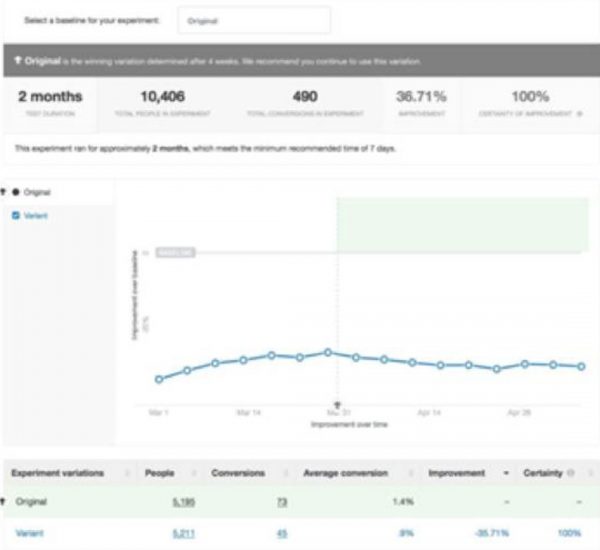

假设我们希望看到,哪些免费体验活动带来了更多的付费订阅者,运行测试, 然后加载一下测试结果:

截止到目前,你并没有看到任何与其他测试工具有所不同的结果。你看到的都是一些司空见惯的的结果,比如测试运行了多长时间,有多少访客访问,以及两个测试选项各自发生了多少转化。在这个例子中,我们可以很清晰的看到变体要明显优于原网址。

是时候将所有注意力集中到变体了,对吗?

这个情况是大多数人停止运行对比测试实验的时候,而事实上我们才刚刚开始。

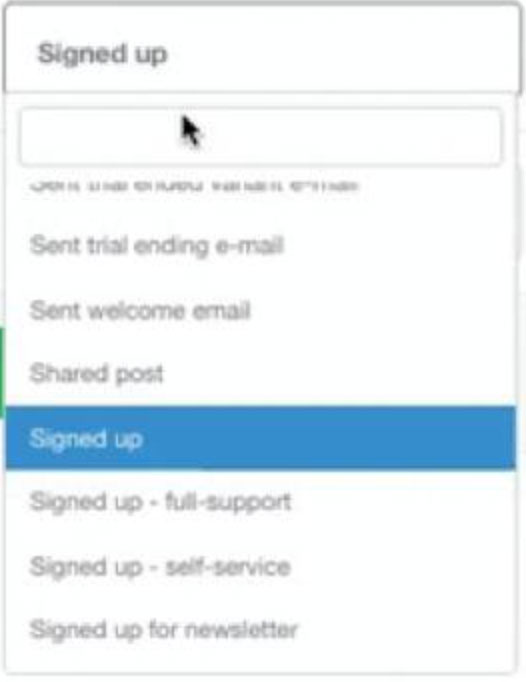

我们之前是想看到到底有多少人注册了,接下来,我们看一下另外一个角度的数据,将转化事件从“注册”切换成 “新用户付费订阅”选项。

点击“运行报告”,出人意外的是,从新用户付费订阅的数量上来讲,原网址居然优于变体网址。因此尽管在“注册”的转化事件上,变体网址要优于原网址,然而从注册并转化成为付费用户的角度来讲,原网址明显优于变体网址。这才是我们真正想要的转化结果。

A/B测试报告是一个很棒的工具,能够帮助你了解最后真正发生转化的测试选项是什么。你可以用A/B测试做更多的事情,包括测试在销售漏斗之外的结果,就像下面这个。

先细分,再测试

与其对所有用户进行盲目的全面测试,不如先进行细分分组。将访客与用户、移动用户与PC用户、通过电子邮件订阅的访客与非订阅者细分分组。当然分类方式有很多,用这种方式来做真正的同类比较能够得出更合理的测试结果。

再次运行测试

测试过程有时候也许看起来有违常理,但这其中的很多波动起伏也许只是海市蜃楼的错觉。这时我们需要再次进行测试,拉长测试时间,这样可以帮助你得到更有意义的测试结果。

在Martin Goodson的“大多数A/B测试的胜出结果是虚无缥缈的”指导中,举例说明了数字统计在排除假数据和混淆对比数据上的影响。

这是一篇简短但具有启发意义的文章,特别是如果你没有统计学背景(像我一样)。

验证假设

大多数A/B测试都基于假设。如果改变了X,对Y的影响是怎样的?但在过程中,会提出很多假设。例如,假设你的访客都来自同样的背景,都是年轻妈妈们,或都是勤劳的渔人,或者都是热爱健身的人。由于错误的人群定向,可能会使结果产生巨大的误差。

所有的这些观点都不足以让你彻底放弃使用对比测试,而你更需要去深层次的去认识你到底需要什么,做怎样深入的功课,这样你就不会仅仅只获得一些空头数据,反之你将得到最后能够全面带来长期增长的数据。

你对现在的对比测试工具有何看法?你的测试结果如何?欢迎留言与我们分享你的观点。

作者简介:

Sherice Jacob通过有说服力的广告文案、友好的用户设计和智能数据分析帮助广告主改善网站设计和提提升转化率。在iElectrify.com可以了解更多,并可以下载免费的网站设计和转化说明。

译者简介:

黄文博,广告行业产品经理,iCDO翻译志愿者。

祝洁,Mediacom NY 广告运营分析,iCDO翻译志愿者

DigiMax

DigiMax